密切跟進OpenAI,國產(chǎn)o1類推理模型陸續(xù)登場

2025年第一個月

,國產(chǎn)o1類模型開始密集更新,發(fā)布者包括“六小虎”中的月之暗面、階躍星辰1月20日

根據(jù)DeepSeek披露的測試結果

作為對R1能力的一種驗證

需要指出的是

由于沒有人類監(jiān)督數(shù)據(jù)介入

定價方面

另一個與DeepSeek-R1顯得針鋒相對的推理類模型,是月之暗面于同一天發(fā)布的K1.5

從去年11月開始

月之暗面給k1.5的定位是“多模態(tài)o1”。簡單而言

,k1.5同時包含多模態(tài)的通用能力和推理能力。據(jù)官方數(shù)據(jù),其Short-CoT(可理解為短思考)模式下的數(shù)學

就R1和k1.5的訓練方式而言,二者都采用了強化學習

DeepSeek利用了數(shù)千條長CoT冷啟動數(shù)據(jù),先是對DeepSeek-V3-Base這一基礎模型進行微調

另外

k1.5一方面將強化學習的上下文窗口擴展到128k

需要指出的是

,k1.5在強化學習中還加入了“長度懲罰”來抑制響應長度,即確立一個公式,根據(jù)響應長度和確定性來分配獎勵值。此外它還采用了“最短拒絕采用方法”(選擇最短的正確響應進行監(jiān)督微調)等方法來抑制響應長度。k1.5的另一個特點是對文本和視覺數(shù)據(jù)進行了聯(lián)合訓練,這使其具備多模態(tài)能力

。不過Kimi也承認,由于部分輸入主要支持文本格式,其面對部分幾何圖題的圖形理解能力還不夠強大。在此之前

,階躍星辰也于1月16日上線了Step Reasoner mini(下稱“Step R-mini”)實驗版。這也是一款具備超長推理能力的推理模型。但它還未完全準備好的是

,目前在測試集中主要對標OpenAI o1-preview和o1-mini,而非o1完整版,當然這應該也與模型大小和訓練方式有關。在國內對標模型上,其表現(xiàn)與QwQ-32B-Preview相近。不過

,階躍星辰強調其“文理兼顧”,使用了On-Policy(同策略)強化學習算法,在保證數(shù)學、代碼、邏輯推理能力的同時至此,從去年9月OpenAI以o1模型變革模型訓練范式之后

但在所有玩家密切跟進o1的同時

例如,在SWE-Bench Verified這一軟件開發(fā)測試集中

,o3得分71.7%,而o1僅有48.9%;在AIME2024測試集中,o3準確率96.7%,而o1為83.3%。o3的一些表現(xiàn),已經(jīng)開始展現(xiàn)AGI(通用人工智能)的初步特征。當然

,o3也存在自己的問題。一方面,o系列模型普遍更擅長邊界清晰、定義明確的任務,對部分現(xiàn)實世界的工程任務處理還存在欠缺。另一方面,近期,o3在FrontierMath這項數(shù)學基準測試中,也因OpenAI資助過相關機構而面臨提前獲取真題的真實能力水平質疑。但擺在國內大模型公司面前的共同問題仍然是明確的。從技術上來說

,無論是DeepSeek-R1還是k1.5,都還沒有成功加入過程獎勵模型和蒙特卡洛樹搜索等更復雜技術,而這是否是模型進一步提高推理能力的關鍵方法,我們還無從得知。另外,從o1到o3

,OpenAI公布的間隔時間僅有三個月,這意味著強化學習帶來的推理階段scaling up的技術范式,顯然比GPT系列模型以年為單位的預訓練范式的節(jié)奏要快。這是國內大模型公司共同要面對的競爭壓力

。OpenAI不僅找到了更明確的技術路徑,并且有足夠的資源快速驗證并推進。當下,國內大模型行業(yè)將比過去更需要加速提效的突破式創(chuàng)新。

熱門資訊 更多 >>

05-31

2024

亞馬遜研發(fā)支出領跑全球 科技巨頭創(chuàng)新競賽日趨激烈

,2023年全球企業(yè)研發(fā)支出總額達到3.1萬億美元

01-02

2025

01-26

2022

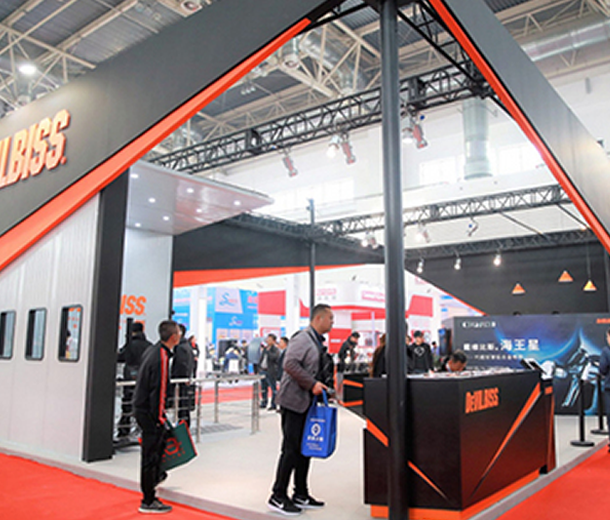

【行業(yè)動態(tài)】2022第一季度延期展會通知匯總

,展品包含了縫前、縫制

03-21

2022

,無縫助力廠商貿(mào)易

03-10

2022

,展會時間/地點會存在不確定因素

、第五屆國際半導體" />

、第五屆國際半導體" />